تشخیص اخبار جعلی با استفاده از روشهای مبتنی بر یادگیری عمیق CNN-RNN

فهرست مطالب

Toggleتا بحال به این موضوع فکر کرده اید خبری که با اطمینان به آن استناد می کنید شاید دروغ محض باشد؟ چطور میتوانیم به صحت کار خبرگذاری ها مطمئن شویم؟ تشخیص اخبار فیک با هوش مصنوعی می تواند پاسخ سوالات شما باشد.با ما همراه باشید.

توسعه اینترنت تأثیر مثبتی بر جامعه دارد زیرا دسترسی گسترده ای به اطلاعات فراهم می کند. در حالی که شبکههای اجتماعی آنلاین و چند رسانهای مزایایی را در ارتباطات و فناوری ارائه میکنند، این نوآوریها به شدت بر جنبه اجتماعی تأثیر میگذارند.

اخیراً به دلیل سهولت ایجاد و توزیع اطلاعات در اینترنت، انتشار اخبار جعلی بیشتر شده است. اخبار جعلی به خودی خود واقعی نیستند، اما برای هدف خاصی واقعی می شوند .

انتشار اخبار جعلی پیامدهای فاجعه بار و خطرات بالقوه ای در زمینه های سیاسی و اجتماعی دارد . بنابراین، تحقیقات در زمینه تشخیص اخبار جعلی به دلیل تأثیر انتشار اخبار جعلی در حال تشدید است.

چگونه تشخیص اخبار فیک با هوش مصنوعی امکان پذیر است؟ این مقاله به طور گسترده چندین عملکرد روشهای یادگیری عمیق را همراه با وضعیت فعلی جاسازی کلمات در مجموعه دادههای اخبار جعلی تجزیه و تحلیل میکند.

ما از جاسازی کلمات از پیش آموزش دیده مانند Word2Vec، Glove و fastText استفاده کردیم وبه این دلیل انتخاب شدهاند که با استفاده از یک مجموعه عظیم برای تولید واژگان کافی آموزش دیدهاند. هر جاسازی کلمه از پیش آموزش داده شده با روش های یادگیری عمیق مربوطه، یعنی CNN، Bidirectional LSTM و ResNet ترکیب می شود تا عملکرد آنها در تشخیص اخبار جعلی مشخص شود.

مشاوره رایگان مسیریادگیری هوش مصنوعی

مقالات

ما همچنین به صورت تجربی نشان میدهیم که عملکرد یادگیری عمیق در تشخیص اخبار جعلی را میتوان با انتخاب جاسازیهای کلمه مناسب افزایش داد.

قبل از شروع مقاله تشخیص اخبار فیک با هوش مصنوعی از شما دعوت می کنیم با مفهوم یادگیری عمیق آشنا شوید.

همه چیز راجع به یادگیری عمیق یا Deep learning به زبان ساده و کاربردی

بخش اول: روش تحقیق در تشخیص اخبار فیک با هوش مصنوعی

این تحقیق از دو مرحله اصلی تشکیل شده است:

مرحله اول: آموزش

1- همانطور که در شکل 1 نشان داده شده است با بازیابی داده های آموزشی ذخیره شده در پایگاه داده شروع می شود

2- دادههای آموزشی از طریق فرآیند پاکسازی دادهها برای پاکسازی دادههای با کیفیت پایین میروند

3- داده های افزوده شده پیش پردازش شده و با استفاده از جاسازی کلمات از پیش آموزش دیده به بردارهای کلمه تبدیل می شوند

4- بردار کلمه تولید شده توسط جاسازی کلمه از پیش آموزش دیده برای آموزش مدل یادگیری عمیق استفاده می شود: CNN، Bidirectional LSTM ، و ResNet

5- مدل آموزش دیده در پایگاه داده ذخیره می شود تا در مرحله آزمایش استفاده شود

مرحله دوم: آزمایش

1- ابتدا با گرفتن داده های آزمایشی از پایگاه داده انجام می شود. داده های تست مستقیماً به همان مرحله پیش پردازش مانند مرحله آموزش بدون گذراندن مراحل پاکسازی و تقویت داده ها می روند

2- مدل آموزش داده شده قبلی از پایگاه داده گرفته شده و برای پیش بینی داده های تست از پیش پردازش شده استفاده می شود. در نهایت، نتایج پیشبینی نمایش داده میشود و برای ارزیابی عملکرد مدل استفاده میشود

1- پاک کردن داده

پاکسازی داده ها فرآیند تصحیح یا حذف داده های با کیفیت پایین از پایگاه داده است. پاکسازی داده ها در این مطالعه با حذف داده های بدون محتوا یا برچسب انجام شد زیرا می تواند در تجزیه و تحلیل و فرآیند تصمیم گیری تداخل ایجاد کند.

2- افزایش داده ها

افزایش دادهها فرآیندی است که معمولا برای ایجاد تعادل در یک مجموعه داده با ایجاد دادههای مصنوعی با استفاده از اطلاعات موجود در آن مجموعه داده انجام میشود.

افزایش داده ها اغلب در فعالیت های مربوط به فرآیند یادگیری برای کاهش کلاس های عدم تعادل استفاده می شود.

این مطالعه از ترجمه برگشتی به عنوان یک روش افزایش داده استفاده می کند که در آن داده های انگلیسی به آلمانی ترجمه شده و سپس به انگلیسی ترجمه می شوند. دادههای تازه تولید شده با دادههای اصلی متفاوت هستند، اما همچنان همان معنی را دارند.

3- پیش پردازش داده ها

داده های افزوده شده از طریق پیش پردازش به جایی میروند که داده های متنی به شکل قابل فهم تری تبدیل می شوند تا فرآیند استخراج ویژگی ساده شود.

پیش پردازش شامل سه مرحله است:

حذف علائم نقطه گذاری

حذف کلید واژه

ریشه یابی یا واژه سازی

پیش پردازش انجامشده در این مطالعه شامل چندین مرحله بود:

فرآیند توکنسازی برای تسهیل پردازش.

تا کردن حروف با حروف کوچک برای هر نشانه کلمه اعمال میشود.

نویسههای غیر الفبا از نشانه حذف میشوند زیرا تأثیر قابلتوجهی بر روند تجزیه و تحلیل ندارند کلماتی که در stopword گنجانده شده اند نیز برای کاهش بار محاسباتی ترسیم می شوند.

در نهایت، واژهسازی برای تبدیل هر نشانه به کلمه ریشه مشترک آن انجام میشود.

4- جاسازی کلمه

جاسازی کلمه یا نمایش کلمه توزیع شده تکنیکی است که کلمات را در بردارهای عددی ترسیم می کند، جایی که کلماتی که معانی مشابهی دارند هنگام تجسم به یکدیگر نزدیک می شوند. این کار را میتوان انجام داد زیرا جاسازی کلمه میتواند اطلاعات معنایی و نحوی یک کلمه را در مجموعه وسیعی ثبت کند .

Word2Vec یکی از جاسازی کلمات از پیش آموزش دیده است که برای به دست آوردن نمایش برداری کلمه استفاده می شود.

Word2Vec دو گزینه معماری، یعنی Continuous Bag of Words (CBOW) و Continuous Skip-gram را ارائه می دهد. CBOW بردار یک کلمه را بر اساس بردار بافت یا کلمات اطراف آن بدون توجه به ترتیب کلمات پیش بینی می کند، در حالی که skip-gram بردار بافت اطراف را بر اساس کلمه میانی پیش بینی می کند.

Global Vector (GloVe) همچنین یک جاسازی کلمه از پیش آموزش دیده محبوب است که از ماتریس تعداد دفعات کلمه در یک پیکره و یک فاکتورسازی ماتریس برای به دست آوردن نمایش برداری از یک کلمه استفاده میکند .

GloVe با تشکیل ماتریسی از تعداد کلماتی که ابتدا از یک مجموعه وسیع تشکیل می شود کار می کند. پس از آن، یک فرآیند فاکتورسازی بر روی ماتریس انجام می شود تا یک نمایش برداری از کلمه به دست آید.

FastText یک جاسازی کلمه از پیش آموزش دیده است که از معماری پیشرفته CBOW Word2Vec استفاده می کند. با استفاده از الگوریتمهای محاسباتی کارآمدتر و ترتیب کلمات، بهبود انجام شد.

FastText همچنین با استفاده از مجموعه کاراکتر n-gram اطلاعات زیرکلمهای را اضافه میکند، زیرا تأثیر خوبی بر بردارهایی دارد که کلماتی را نشان میدهند که به ندرت ظاهر میشوند یا غلط املایی دارند

این مطالعه به بررسی و مقایسه اثر جاسازی کلمات از پیش آموزشدیده، یعنی Word2Vec، GloVe و fastText بر عملکرد مدل در تشخیص اخبار جعلی میپردازد.

5- یادگیری عمیق

این مطالعه از روش یادگیری عمیق برای تشخیص اخبار جعلی استفاده می کند. سه روش مختلف یادگیری عمیق، یعنی CNN، Bidirectional LSTM و ResNet مورد آزمایش قرار گرفتند تا مشخص شود کدام روش بهترین عملکرد را در تشخیص اخبار جعلی دارد.

معماری CNN در این مطالعه از تحقیقات Kaliyar و همکاران اقتباس شده است و در شکل 3 قابل مشاهده است.

یک لایه ورودی با 1000 بعد به لایه جاسازی متصل است که ابعاد آن با ابعاد جاسازی کلمه از قبل آموزش دیده تعیین می شود. لایه embedding به سه لایه کانولوشن یک بعدی با اندازه هسته های مختلف متصل است، که در آن هر لایه کانولوشن نگاشت ویژگی متفاوتی را تولید می کند.

هر لایه کانولوشن برای فشرده سازی ویژگی ها و کنترل بیش از حد به لایه max-pooling متصل می شود.

یک لایه پیوسته ویژگی های به دست آمده توسط هر لایه max-pooling را ترکیب می کند.

لایه الحاقی سپس با دو لایه پیچشی و یک لایه max-pooling برای استخراج ویژگی های بیشتر متصل می شود.

در نهایت لایه سراسری max-pooling به لایه کاملا پیوسته و لایه خروجی متصل می شود.

شکل 4 معماری Bidirectional LSTM مورد استفاده در این مطالعه را توصیف می کند، جایی که یک لایه ورودی با 1000 بعد و به دنبال آن یک لایه جاسازی وجود دارد. معماری با لایه Bidirectional LSTM ادامه می یابد، جایی که LSTM برای هر دو جهت یکسان است. علاوه بر این، لایه max-pooling جهانی، لایه کاملا پیوسته و لایه خروجی کلاس را پیشبینی میکنند.

معماری ResNet که در این مطالعه استفاده شده در شکل 5 نشان داده شده است.

معماری ResNet با استفاده از معماری CNN در شکل 3 ساخته شده است، جایی که دو مجموعه از لایههای کانولوشن و لایه max-pooling با بلوک باقیمانده جایگزین شدهاند. انتظار میرود افزودن این بلوک باقیمانده مقاومت معماری را در برابر شیب محو شده افزایش دهد و اطلاعاتی که قبلاً آموختهاید دوباره یاد گرفته شود و ماندگاری بیشتری داشته باشد.

بخش دوم: راه اندازی آزمایش تشخیص اخبار فیک به روش یادگیری عمیق

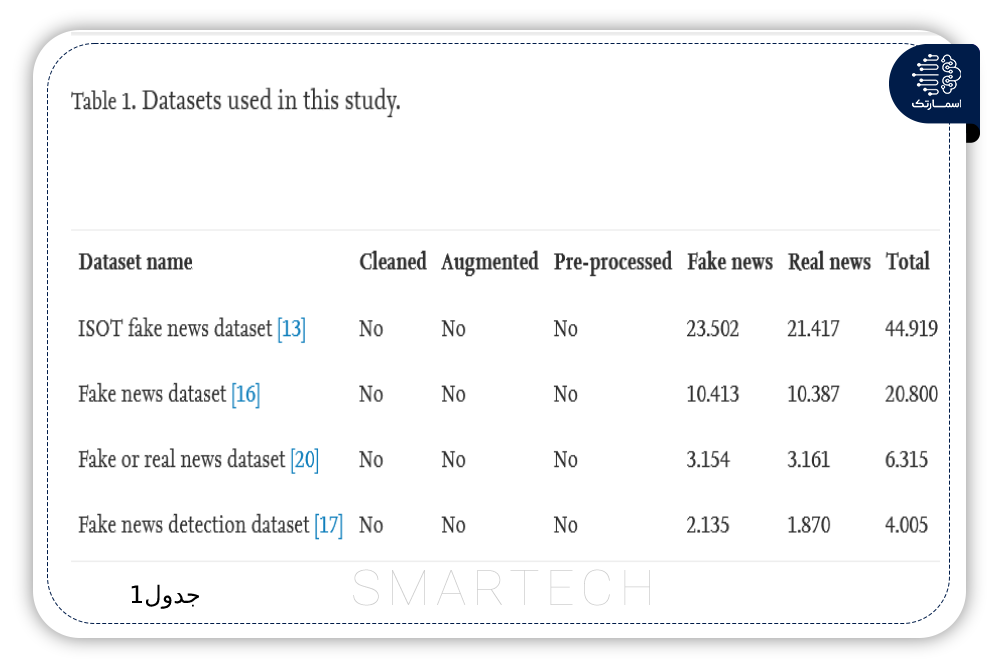

آزمایشها در این مطالعه با استفاده از چهار مجموعه داده مختلف انجام شد ، یعنی مجموعه دادههای اخبار جعلی ISO ، مجموعه دادههای اخبار جعلی ، مجموعه دادههای اخبار جعلی یا واقعی و تشخیص اخبار جعلی مجموعه داده.

ویژگی های هر مجموعه داده شرح داده شده در جدول 1 نشان می دهد که چهار مجموعه داده دارای مقادیر متفاوتی از داده ها هستند. این می تواند در تعیین توانایی یک مدل یادگیری عمیق برای مدیریت مقادیر زیاد یا کوچک داده مفید باشد.

متأسفانه، هر مجموعه داده مراحل پاکسازی دادهها، تقویت دادهها و پیشپردازش دادهها را طی نکرده است زیرا هنوز ردیفهای داده خالی، عدم تعادل دادهها، کلمات توقف باقیمانده و کلمات الصاق شده وجود دارد. بنابراین، فرآیند پاکسازی داده ها، تقویت داده ها و پیش پردازش داده ها ضروری است تا داده ها برای تجزیه و تحلیل بیشتر آماده شوند. مجموعههای دادهای که پاکسازی، افزودهشده و از پیش پردازش شدهاند نیز برای عموم قابل دسترسی هستند .

آزمایشها با کمک TensorFlow، NLTK، pandas، و کتابخانهها و دستگاههای Sicit-learn انجام شد . برخی از آزمونهای انجام شده در این مطالعه برای تعیین تأثیر بر عملکرد مدل به دست آمده، شامل آزمایش روش افزایش دادهها، روش بهینهساز، فراپارامتر اندازه دستهای و آزمایش نهایی میباشد.

. هر مقداردر آزمایش، بر روی چهار مجموعه داده مختلف با استفاده از سه روش یادگیری عمیق، یعنی CNN، Bidirectional LSTM ، و ResNet، همراه با یکی از سه جاسازی کلمه از پیش آموزش داده شده مانند Word2Vec، GloVe و fastText بررسی میشود.

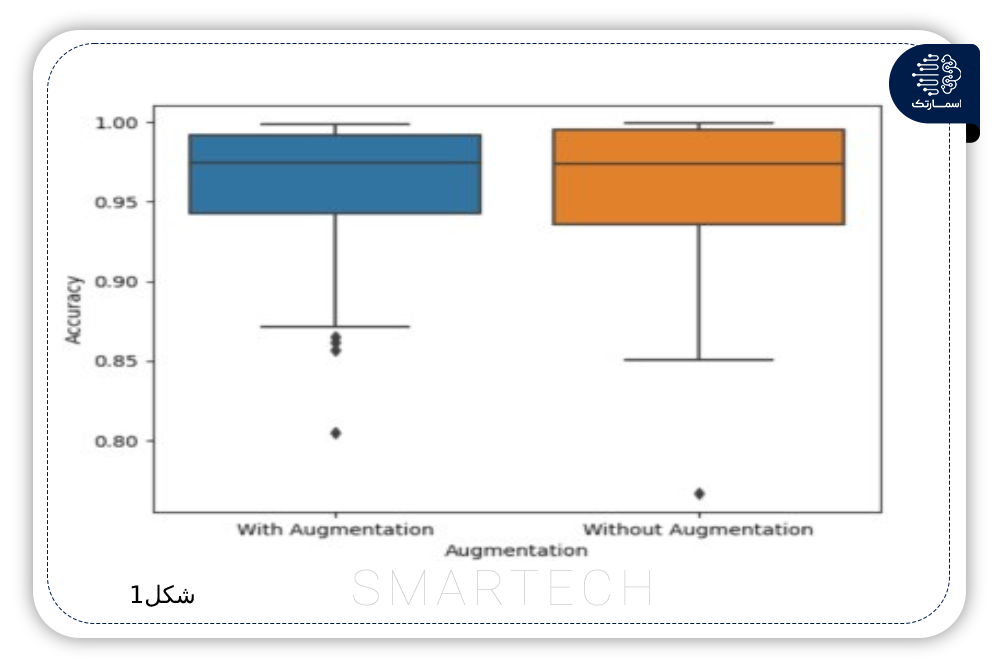

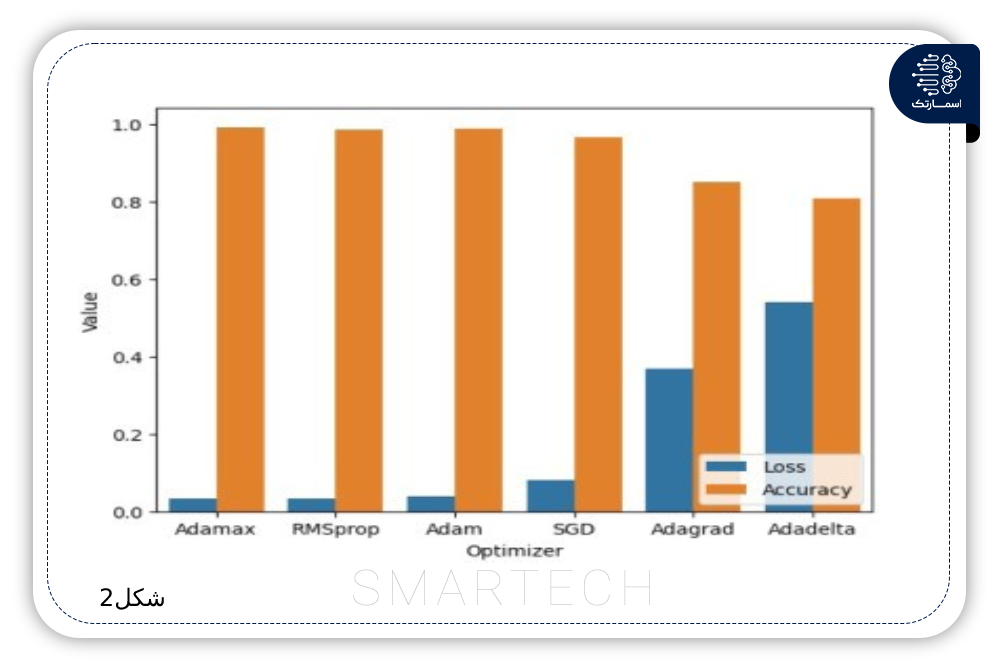

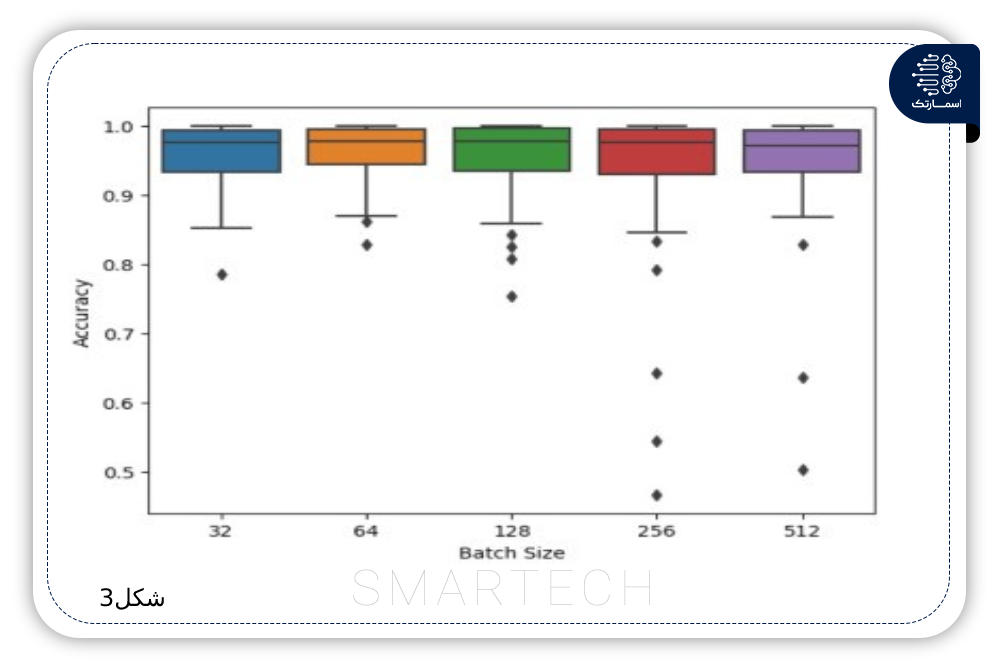

فرآیند ارزیابی هر مقدار در آزمایش از تجسم در یک نمودار جعبه یا نوار استفاده می کند. روش افزایش داده ها دو مقدار یعنی داده با افزایش و داده بدون افزایش را آزمایش می کند. هفت روش تست شده در روش بهینه ساز وجود دارد: SGD، RMSprop، Adam، Adadelta، Adagrad، Adamax و Nadam. تست بعدی فراپارامتر اندازه دسته ای است که در آن پنج مقدار به ویژه 32، 64، 128، 256 و 512 مورد آزمایش قرار می گیرند.

در نهایت، آزمایشی انجام می شود که مقادیر یا روش هایی را که از آزمایش های قبلی انتخاب شده اند ترکیب می کند تا عملکرد نهایی مدل یادگیری عمیق تعیین شود.

بخش سوم : نتیجه و بحث

1- افزایش داده ها

اولین آزمایش ، برای تعیین اثرات فرآیند افزایش داده ها انجام شد. شکل1 نشان میدهد دادههای افزوده شده دارای میانگین بالاتر و اندازههای جعبه کوچکتر هستند که نشاندهنده نتایج متمرکزتر و سازگارتر است.

2- تنظیم فراپارامتر

فرآیند تنظیم فراپارامتر با آزمایش دو مقدار، یعنی بهینه ساز و اندازه دسته ای، برای بهبود عملکرد مدل یادگیری عمیق انجام می شود. شکل 2 نتایج آزمایش روش بهینه ساز را نشان می دهد.

Adamax به دلیل بالاترین عملکرد با تلفات کمتر به عنوان روش بهینهساز برای آزمایش نهایی استفاده میشود. نتایج آزمایش اندازه دسته ای در شکل 3 نشان می دهد که مقدار اندازه دسته 64 با به دست آوردن بالاترین مقدار در مقادیر حداقل، چارک اول، میانه، میانگین و حداکثر بهینه ترین مقدار است.

فرآیند آزمایش نهایی شامل چهار مجموعه داده مختلف است. این بر روی هر یک از معماری های یادگیری عمیق که با استفاده از فراپارامتر انتخاب شده کامپایل شده و سپس با جاسازی کلمه از پیش آموزش دیده ترکیب شده است، انجام می شود. معیارهای ارزیابی، مانند دقت،درستی، یادآوری، امتیاز F1 و ماتریس سردرگمی، برای ارزیابی عملکرد مدل استفاده میشوند.

3- مجموعه داده اخبار جعلی ISOT

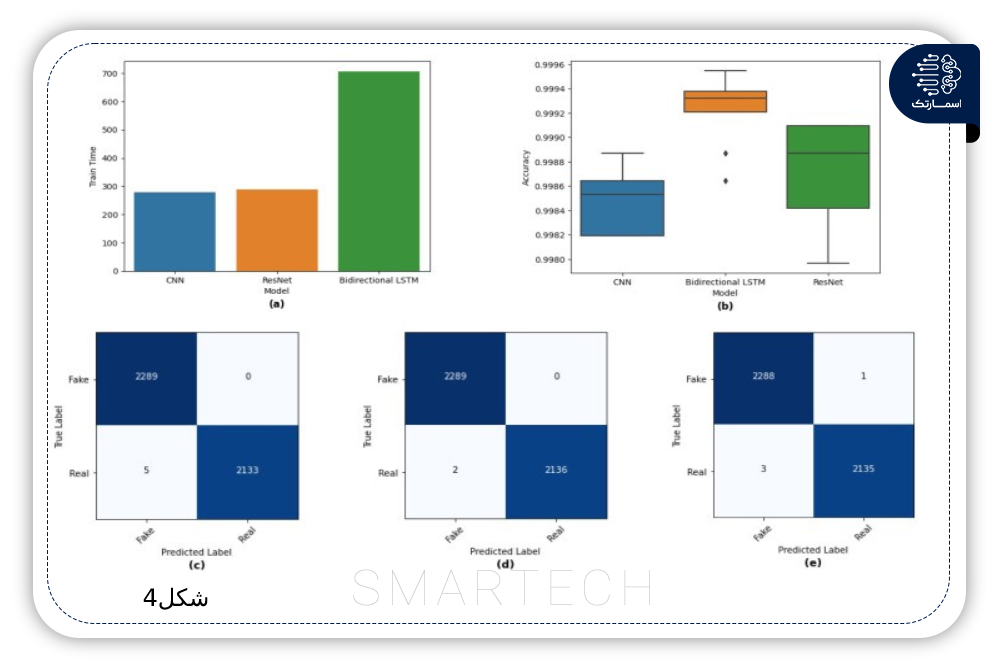

مجموعه داده اخبار جعلی ISOT اولین مجموعه داده مورد استفاده در آزمایش نهایی است. نتایج آزمایش در مجموعه داده اخبار جعلی ISOT در شکل 4 نمایش داده شدهاست.

. بر اساس شکل 4(a)، فرآیند آموزش با استفاده از مجموعه داده اخبار جعلی ISOT در CNN سریع ترین و Bidirectional LSTM طولانی ترین است. در عملکرد آزمایشی نشان داده شده در شکل 4(b)، Bidirectional LSTM از دو مدل دیگر بهتر عمل می کند. خلاصه ای از نتایج پیش بینی هر مدل به شکل یک ماتریس سردرگمی در شکل 4 (c)، (d) و (e) نشان داده شده است، که در آن هر مدل بیشتر اخبار را به عنوان اخبار جعلی پیش بینی می کند.

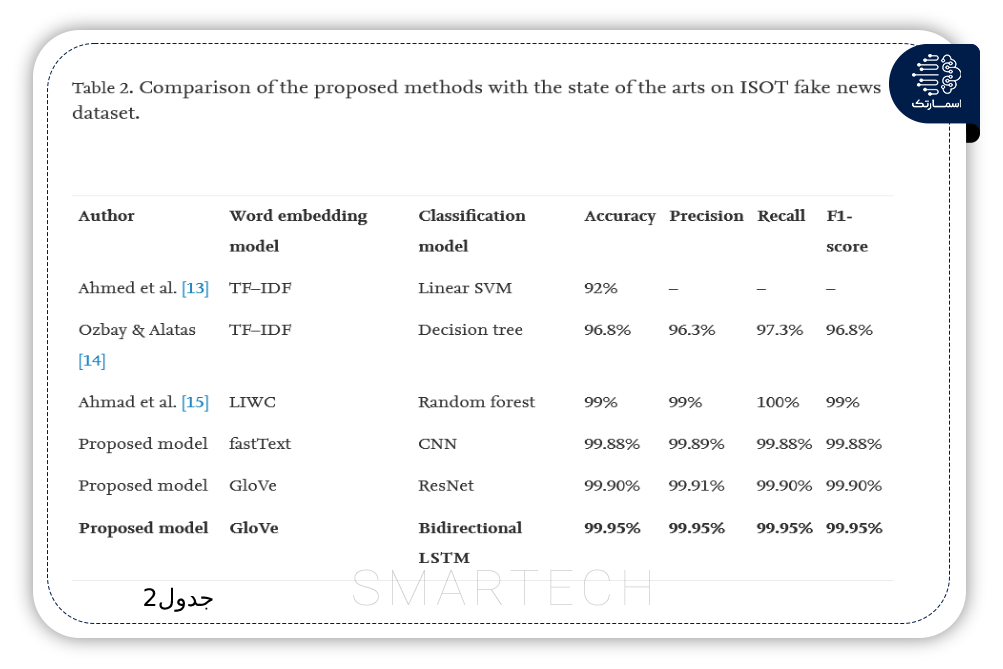

مقایسه نتایج آزمایش در مجموعه دادههای اخبار جعلی ISOT که در جدول 2 توضیح داده شده است نشان میدهد که مدلهای پیشنهادی بهترازسایرمطالعات عمل کردند.

مدل Bidirectional LSTM + GloVe با دقت 99.95 درصد، دقت، فراخوانی و امتیاز F1. مدل ResNet + GloVe با عملکرد 99.91 درصد برای درستی و 99.90 درصد برای دقت، یادآوری و امتیاز F1 دنبال شد. در نهایت، مدل CNN + fastText دارای افزایش عملکرد 99.89٪ درستی و 99.88٪ برای دقت، یادآوری و امتیاز F1 است.

4- مجموعه داده اخبار جعلی

دومین مجموعه داده مورد استفاده در آزمایش نهایی، مجموعه داده اخبار جعلی بود، که نتایج در شکل 5 و جدول 3 نشان داده شدهاست. باتوجه به شکل 5a)) فرایند آموزش در CNN سریعترین و Bidirectional LSTM طولانیترین است.

Bidirectional LSTM همچنان با به دست آوردن بالاترین مقدار حداقل تا حداکثر در عملکرد تست نشان داده شده در شکل 5(b) از دو مدل دیگر بهتر عمل می کند. ماتریس سردرگمی LSTM دوطرفه در شکل 5(d) همچنین دارای مثبت کاذب جزئی (FP) و منفی کاذب (FN) در مقایسه با ماتریس سردرگمی مدل دیگر در شکل 5(c) و (e) است.

مقایسه نتایج در مجموعه دادههای اخبار جعلی شرح داده شده در جدول 3 نشان میدهد که مدلهای پیشنهادی با Bidirectional LSTM عملکرد بهتری از سایر مطالعات داشتند. نتایج آزمایش نشان می دهد که مدل Bidirectional LSTM + fastText بهترین عملکرد را با دقت و امتیازF1 98.65% ،درستی 98.64٪ و فراخوانی 98.66٪ ارائه می دهد.

مدل ResNet + fastText عملکرد 98.11% را برای دقت و درستی، 98.09% یادآوری و 98.1% امتیاز F1 را به دست میآورد. آخرین مدل پیشنهادی دارای 96.92٪، 96.86٪، 96.98٪، و 96.91٪ دقت، درستی،فراخوانی، و امتیاز F1، به ترتیب، متعلق به CNN + مدل fastText است.

5- مجموعه داده اخبار جعلی یا واقعی

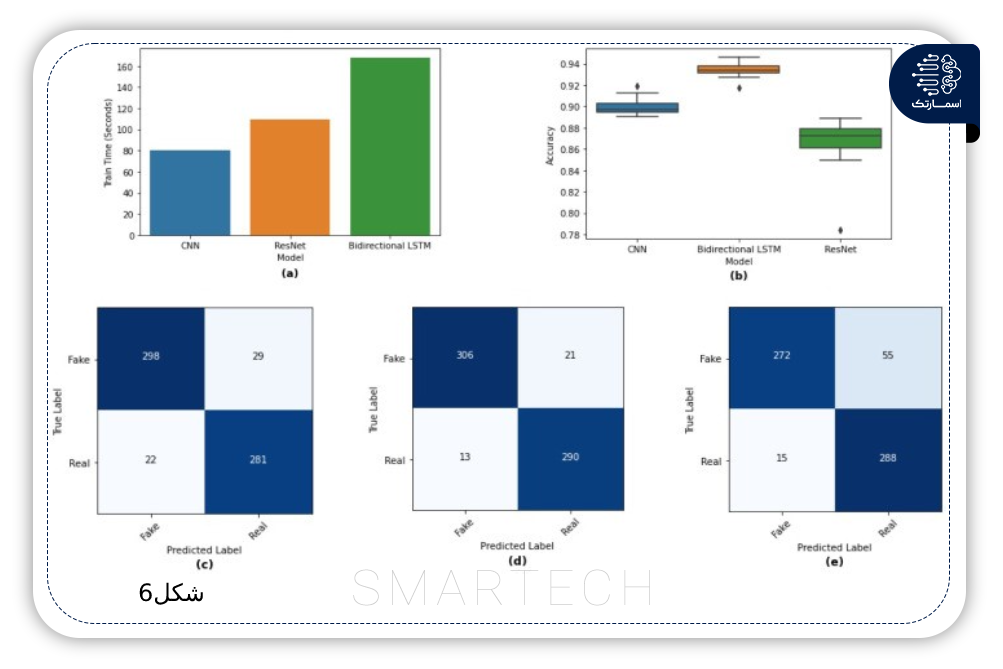

مجموعه داده اخبار جعلی یا واقعی سومین مجموعه داده مورد استفاده در آزمایش نهایی است. بر اساس شکل 6(a)، فرآیند آموزش درCNN سریعترین و Bidirectional LSTM طولانیترین است.

در عملکرد آزمایشی نشاندادهشده در شکل6(b)، Bidirectional LSTM بالاترین را در مقدار حداقل تا حداکثر با FP کمترو FN نشاندادهشده در شکل6(d) درمقایسه با ماتریس سردرگمی مدل دیگر در شکل 6 (e,c) به دست میآورد.

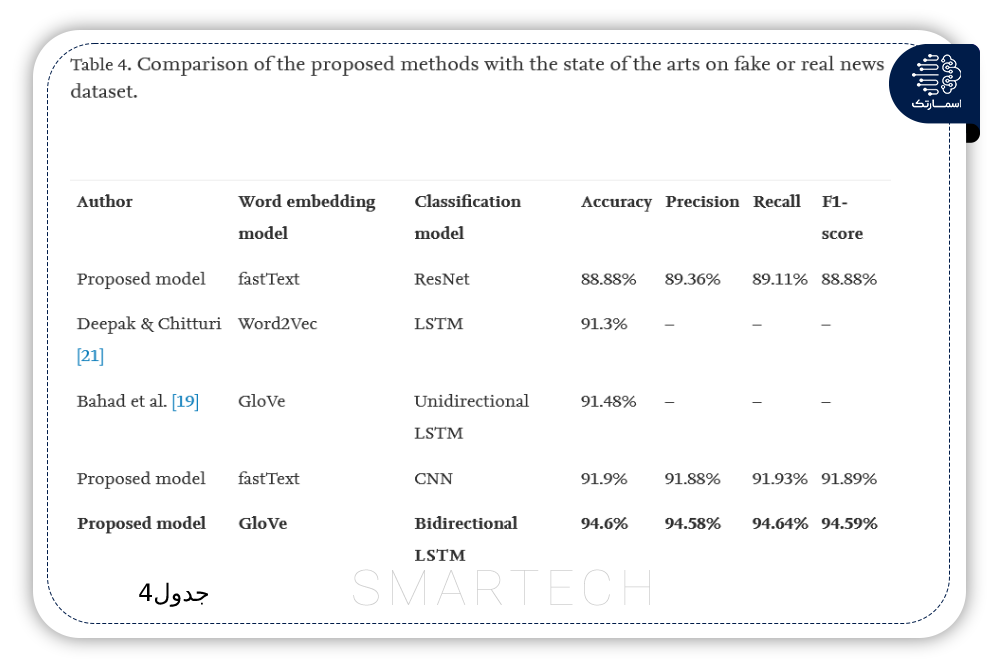

جدول 4 نشان میدهد که مدلهای پیشنهادی با CNN و Bidirectional LSTM عملکرد بهتری از سایر مطالعات داشتند.

مدل Bidirectional LSTM + GloVe دارای بالاترین عملکرد با دقت 94.6%، درستی 94.58%، فراخوانی 94.64% و امتیازF1 94.59%است. این عملکرد توسط مدل CNN + fastText با دقت،درستی ، یادآوری و مقادیرامتیازF1 91.9%، 91.88٪، 91.93٪ و 91.89٪ دنبال شد. کمترین عملکرد توسط مدل ResNet + fastText با دقت، درستی ،یادآوری و مقادیر امتیازF1 88.88% ، 89.36٪، 89.11٪ و 88.88٪ به دست آمد.

6- مجموعه داده تشخیص اخبار جعلی

آخرین مجموعه داده مورد استفاده در آزمایش نهایی، مجموعه داده تشخیص اخبار جعلی بود. نتایج آزمایش در شکل 7 نشان داده شده است

با توجه به شکل 7(b)فرآیند آموزش در CNN سریع ترین و Bidirectional LSTM طولانی ترین است. در عملکرد آزمایشی نشان داده شده در شکل 7(b)، Bidirectional LSTM همچنان بیشترین مقدار را در حداقل تا حداکثر به دست می آورد. ماتریس سردرگمی Bidirectional LSTM در شکل 7(d) همچنین دارای FP و FN کمتری در مقایسه با ماتریس سردرگمی مدل دیگر در شکل 7(c) و (e) است.

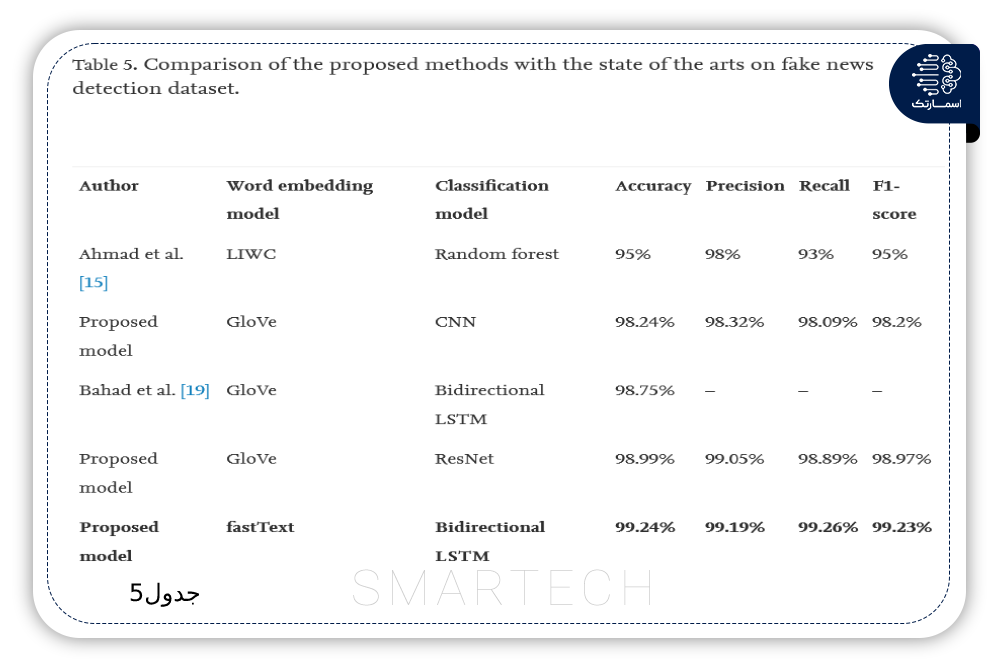

مقایسه نتایج آزمایش در مجموعه دادههای تشخیص اخبار جعلی که در جدول 5 توضیح داده شده است، نشان میدهد که مدلهای پیشنهادی با ResNet و Bidirectional LSTM عملکرد بهتری از سایر مطالعات داشتند.

مدل Bidirectional LSTM + fastText با عملکرد 99.24% دقت، 99.19% درستی، 99.26% فراخوانی و 99.23% امتیاز F1 مجدداً از سایر مدل ها بهتر عمل می کند. نتایج آزمایش همچنین نشان می دهد که ResNet + GloVe با عملکرد 98.99% دقت، 99.05% درستی، 98.89% فراخوان و 98.97% امتیاز F1 در جایگاه دوم قرار دارد. CNN + GloVe با مقدار دقت 98.24٪، 98.32٪ درستی، 98.09٪ یادآوری، و امتیازF1 98.2% عمل میکند.

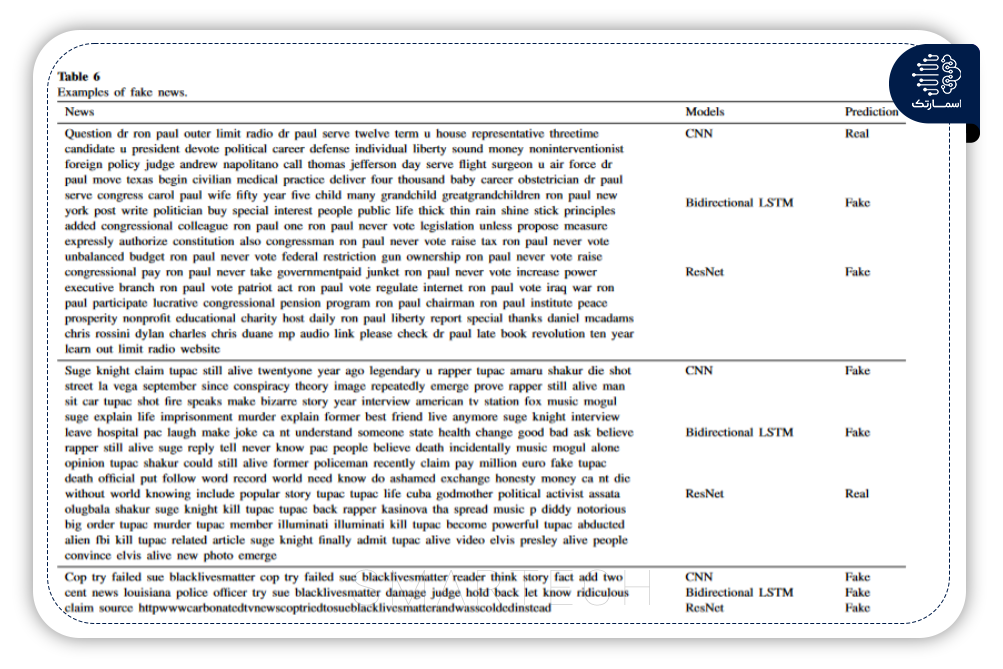

جدول 6 نمونههایی از اخبار جعلی و پیشبینی هر مدل نسبت به اخبار را نشان میدهد. اولین خبر دارای محتوای طولانی است و از یک اسم مناسب استفاده می کند، Bidirectional LSTM و ResNet با موفقیت اخبار را به عنوان اخبار جعلی طبقه بندی کردند، اما CNN به دلیل طولانی بودن محتوا و اسم ناموفق بود زیرا اخبار جعلی تمایل به محتوای کوتاه دارند و از یک اسم مشترک استفاده می کنند.

خبر دوم نیز دارای محتوای طولانی و استفاده از اسامی خاص، گفتار گزارش شده و جملات تحریک آمیز است. CNN و Bidirectional LSTM با موفقیت این خبر را به دلیل جمله تحریک آمیز به عنوان اخبار جعلی طبقه بندی کردند، اما ResNet شکست خورد.

آخرین خبر دارای محتوای کوتاه، لینک خارجی و اسامی رایج است تا هر مدل به راحتی بتواند اخبار را به عنوان اخبار جعلی طبقه بندی کند

این مطالعه یک فرآیند افزایش داده را برای هر مجموعه داده با استفاده از روش ترجمه برگشتی برای کاهش عدم تعادل کلاس اعمال می کند. آزمایشهایی برای تعیین تأثیر افزایش دادهها بر عملکرد مدل حاصل انجام میشود. نتایج آزمون نشان می دهد که افزایش داده ها به ویژه در بهبود ثبات عملکرد مدل تأثیر مثبتی دارد.

چندین روش یادگیری عمیق مانند CNN، Bidirectional LSTM و ResNet نیز در این مطالعه با استفاده از چهار مجموعه داده مختلف مورد ارزیابی قرار گرفتند.

تشخیص اخبار جعلی با هوش مصنوعی ؛چگونه مجهز شویم؟

در این مقاله آموختیم که هر روش یادگیری عمیق با جاسازی کلمات از پیش آموزش دیده، یعنی Word2Vec، GloVe و fastText ترکیب شده است. بر اساس نتایج آزمایش، Bidirectional LSTM از CNN و ResNet در تمام مجموعه داده های آزمایشی بهتر عمل کرد. GloVe و fastText نیز نتایج خوبی به دست آوردند زیرا هرکدام میتوانند در دو مجموعه داده متفاوت برتری داشته باشند.

ما می توانیم سریعتر و راحت تر از چیزی که فکر می کنیم در زمینه هوش مصنوعی پیشرفت کنیم. مجموعه اسمارتک با استفاده از علم اساتید مطرح این حوزه بستر مناسبی را برای آموزش و مهارت شما تدارک دیده است.

دوره جامع هوش مصنوعی

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره هوش مصنوعی دیگر…

دوره کسب درآمد از هوش مصنوعی

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره همانطور که یادگیری…

دوره پردازش زبان طبیعی

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره ما انسان ها…

دوره بینایی ماشین

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره ما انسان ها…

دوره یادگیری عمیق

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره یادگیری عمیق زیرشاخهای…

دوره یادگیری ماشین

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره اگر بخواهیم به…

دوره پایتون و ریاضیات هوش مصنوعی

معرفی دوره چرا این دوره؟ پس از پایان دوره چرا اسمارتک سوالات متداول ثبت نام معرفی دوره این دوره 30…

وبینار هوش مصنوعی و هوش طبیعی

هوش مصنوعی و هوش طبیعی: یه عالمه فرصت و چالش!

همیشه دوست داشتی بدونی هوش مصنوعی چیه و چطوری کار میکنه؟تو این وبینار، با هوش مصنوعی و هوش طبیعی آشنا میشی و میفهمی که چه جوری میتونن زندگی و کارمون رو تغییر بدن.از فرصتهای جذاب هوش مصنوعی میشنوی و با چالشهای پیش روی اون آشنا میشی.پس یه فرصت به خودت بده و تو این وبینار شرکت کن!مطمئنم که پشیمون نمیشی

دیدگاهتان را بنویسید